مقدمه

مدلهای زبانی بزرگ یا LLMها به عنوان یکی از دستاوردهای بزرگ در حوزه هوش مصنوعی، امکانات مختلفی را برای تنظیم و کنترل رفتار خود ارائه میدهند. این پارامترها به محققان و توسعهدهندگان این امکان را میدهند که خروجیهایی مطابق با نیازهای خاص خود تولید کنند. در این مقاله، به بررسی ۵ پارامتر رایج LLM میپردازیم و با مثالهایی روشهای صحیح تنظیم این پارامترها را توضیح میدهیم.

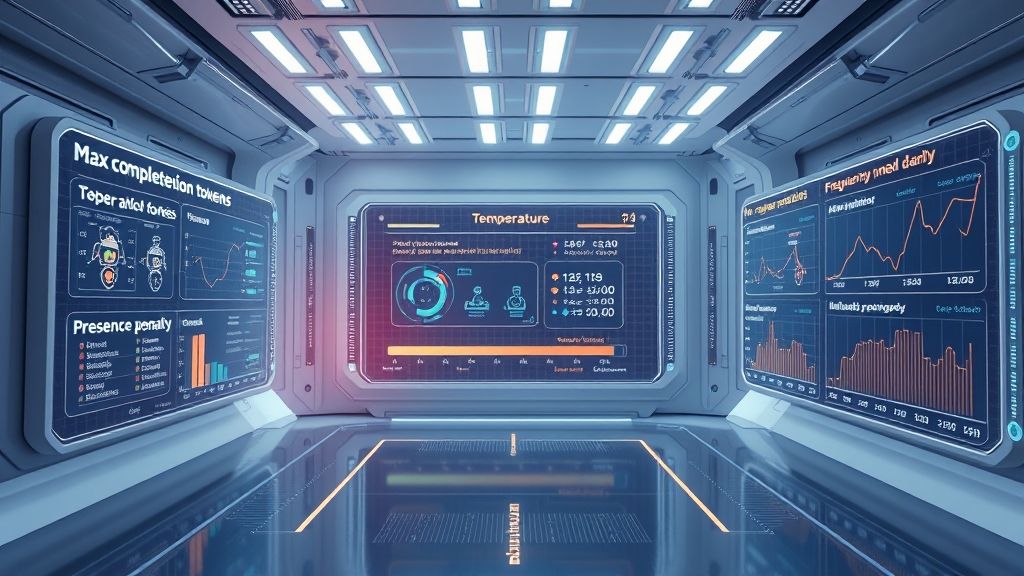

۱. حداکثر تعداد توکنهای تولیدی (max_completion_tokens)

پارامتر max_completion_tokens به شما اجازه میدهد تا حداکثر تعداد توکنهایی که مدل میتواند در یک پاسخ تولید کند را مشخص کنید. توکنها در واقع کلمات و علامتهای نگارشی کوچکی هستند که مدل هنگام تولید متن از آنها استفاده میکند. برای مثال، اگر شما حداکثر تعداد توکنها را ۵۰ تنظیم کنید، مدل نمیتواند بیشتر از ۵۰ توکن در پاسخ خود تولید کند. این پارامتر به ویژه در سناریوهای محدودیت زمانی یا زمانی که نیاز به خروجیهای مختصر دارید، مفید است.

۲. دما (temperature)

پارامتر temperature نیز یکی از ابزارهای کلیدی برای کنترل تصادفی بودن پاسخهای مدل است. این پارامتر به شما اجازه میدهد تا سطح خلاقیت یا حرکت در تولید متن را تنظیم کنید. با انتخاب دمای بالا (مثلاً ۱.۰)، مدل میتواند پاسخهای بسیار متنوع و شاید غیرقابل پیشبینی ایجاد کند. در مقابل، اگر دما را پایین (مثلاً ۰.۲) تنظیم کنید، مدل تمایل بیشتری به تولید پاسخهای مشخص و تکراری خواهد داشت. این انتخاب بسته به نوع کاربری که از مدل انتظار دارید، متفاوت خواهد بود.

۳. پروکسی احتمالی (top_p)

پارامتر top_p که گاهی با نام nucleus sampling نیز شناخته میشود، روشی برای تعیین دامنه کلمات بالقوه برای انتخاب از آنها است. اگر شما این پارامتر را روی ۰.۹ تنظیم کنید، مدل تنها از ۹۰٪ بالای توزیع احتمال کلمات استفاده میکند. این روش برای مدیریت تنوع پاسخها بسیار موثر است و میتواند به عمق معانی و لحن جوابها کمک کند.

۴. جریمه حضور (presence_penalty)

پارامتر presence_penalty به شما این امکان را میدهد که تعیین کنید آیا مدل اجازه دارد یک کلمه خاص را بیش از یک بار در پاسخ خود تکرار کند یا نه. این پارامتر در وضوح و تنوع محتوای تولید شده بسیار تاثیرگذار است. اگر شما این پارامتر را افزایش دهید، مدل تمایل کمتری به تکرار کلمات خواهد داشت و این به جلوگیری از یکنواختی خروجی کمک میکند.

۵. جریمه فرکانس (frequency_penalty)

این پارامتر مشابه presence_penalty اما با یک تفاوت کلیدی است؛ frequency_penalty به شما این امکان را میدهد که فرکانس کل یک کلمه در پاسخ را کنترل کنید. اگر یک کلمه از قبل در متن استفاده شده باشد، این پارامتر میتواند باعث کاهش احتمال تکرار آن کلمه شود. بنابراین، تنظیم صحیح این پارامتر به شما کمک میکند تا متنهای تولید شده هم از نظر لغوی و هم از نظر معنایی متنوعتر باشند.

جمعبندی

در این مقاله، به بررسی ۵ پارامتر رایج LLM پرداختیم و هر یک را با مثالهای کاربردی توضیح دادیم. با توجه به پیشرفتهای روزافزون در حوزه هوش مصنوعی و به ویژه مدلهای زبانی بزرگ، فهم این پارامترها و کاربرد صحیح آنها میتواند به شما در بهبود خروجیهای تولید شده کمک شایانی کند. بنابراین، با استفاده صحیح از این پارامترها، میتوانید تجربه بهتری از تعامل با هوش مصنوعی داشته باشید.